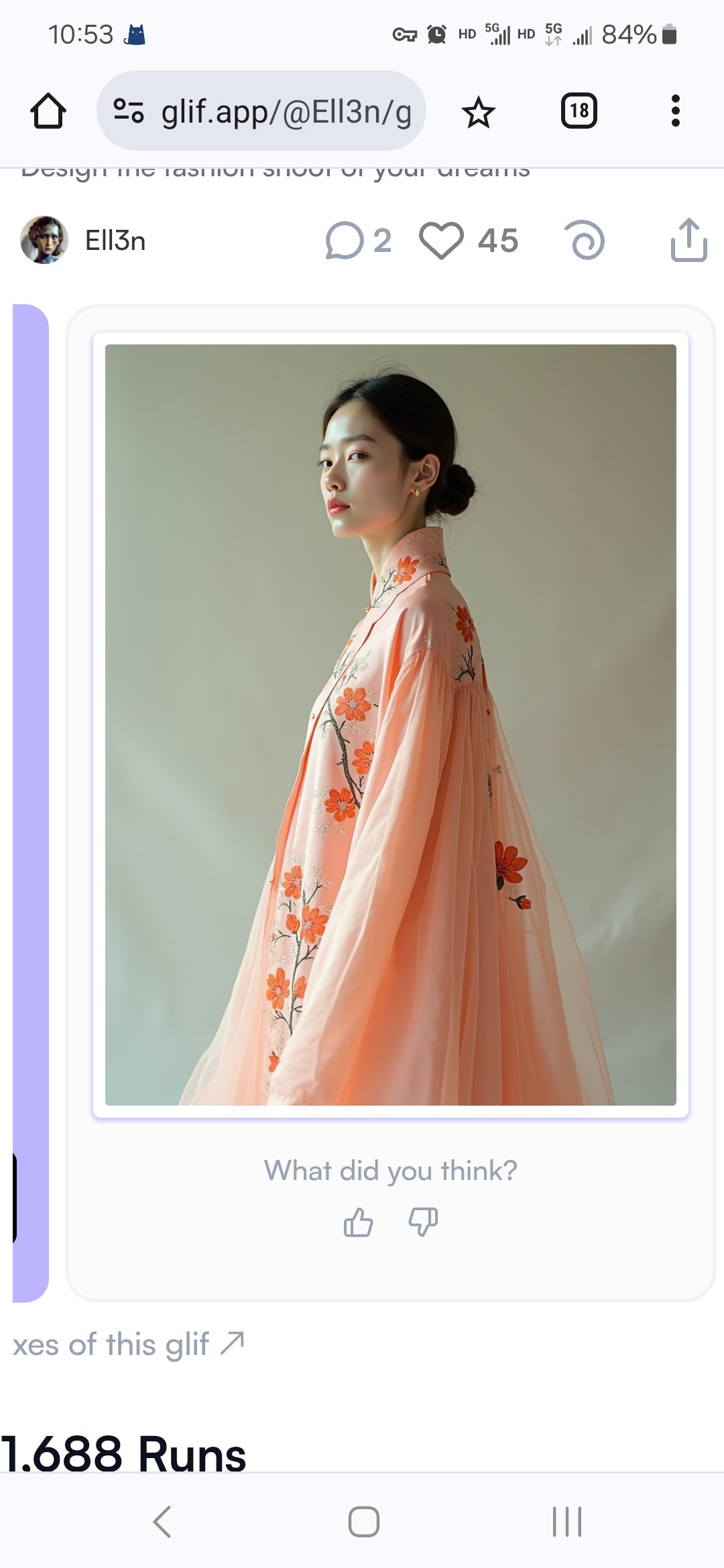

一秒变身时装设计师

请欣赏国内第一场古典时尚AI时装秀

可以一秒变身时装设计师了。Glif首选的是欧美模特,欧美设计风格,我只认识Diro。能理解中国诗句,没有出现国内一开始的生搬硬造,这很一出场就强了,自研的,不是用别人的,这就是百度,腾讯的差距。

后续应用计划:1高仿搬回来,得雇码农。网上搬的一上来都是吃。2,可以配套生成视频。直接走秀,办一场,就是国内第一AI时装秀。技术上可以。上海搞过国内第一个人与AI合作演奏会。3,内容。这是保障可以持续的创作素材,不要像AI写小说很快江郎才尽,不知道让人家写啥。风格就是:古典时尚,中国古典时尚等等。利用群众都可以公开使用的资源:古诗现代诗!然后不同的主题,开发一系列题材。

综上:1,干成一个业务,用Glif直接可以办。2,可以独立办一个时装设计平台,用户使用非常简单,可以,这样就不会担心内容创新,抖音人才遍布。只是技术上国内一开始都是生搬硬套的技术成熟至少半年,当然这是借用美国大模型,不用他们开发模型,质量,速度就可以保证了。

问题:现在设计风格都是欧美的,这个现在没办法,中国设计影响力还有差距。自就婚纱也是美籍华人。但以现在的效果,中国风的应该没问题。

意义:开辟中国时装设计新赛道:中国古典时尚设计风。不知道业内有没有,应该有。提升中国时装设计层次。AI时装设计方面可以跟世界同步响应。

人手一个大模型还要多久

微软让每个人桌面上都有一台电脑,每台电脑都装着Windows系统。

又引领了每个人电脑上都跑着一个大模型:chatGPT!

基本上实现了人手一个大模型,但为什么还有:人手一个大模型还要多久?

因为这个大模型是通用的,不是个性化的大模型,这之间的区别是:

你想让它替“你”,不能实现。

在这方面,最近毒舌AI爆火,似乎有希望,他们选的路线也很好,毒舌当代名人,容易引起关注度,这种路数中外一如。之前character复活历史名人,但似乎是通用的,也没起什么风浪。

如果能毒舌每个人,每个领域,就可以人手一个大模型,人手一个“你”的大模型,人手一个专业模型,绘画,音乐,视频,写作都做的很好了,其他行业的还没了解,应该没什么问题。

人手一个你的大模型后,就是实现听话的“你”:

chatGPT让搜索查找变成了搜索问答,但除了问答,要完成其他任务,是你围着它转,而不是它给你做,这个你试下编程,写小说都是,围着它转也没问题,关键是能听话不会听话,不能改,不能现学,还得等他再“提前训练”,用户又不能变成专业教练,只能等厂家训练了,这个才是人手一个大模型的核心问题,不能个性化学习改进。

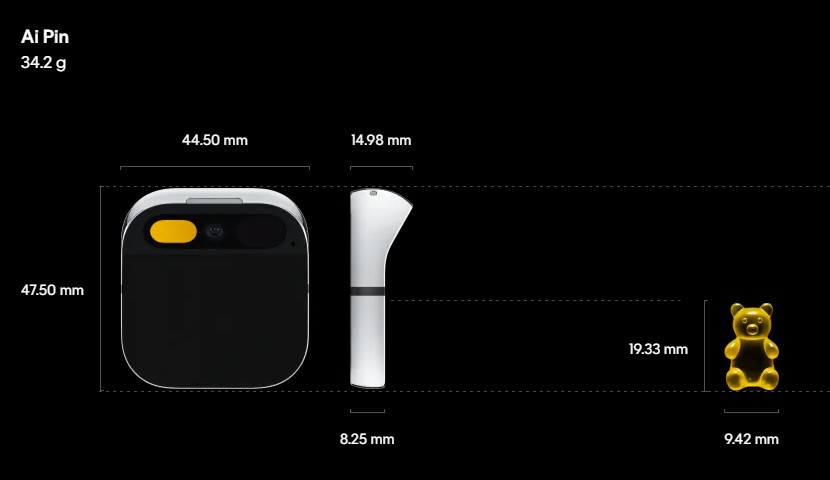

现在,创建你的智能体

去年春,美国有AI平台复活了拿破仑等历史人物,创建了各种“数字克隆人”提供交流体验,这应该算是最早的“大模型智能体”。

微软小冰已经在试验用户创建克隆人,利用自己创建的克隆人进行各种社交和商业活动。

国内互联网,百度智能体今年推出较早,但是不是面向用户的,而是开发者,你创建一个智能体,只是个只能自己看的Demo。

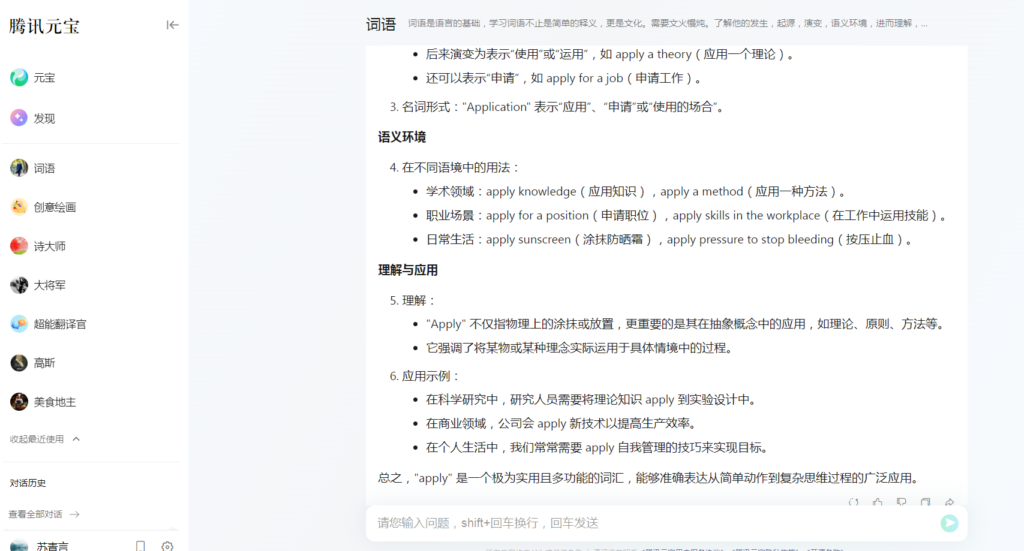

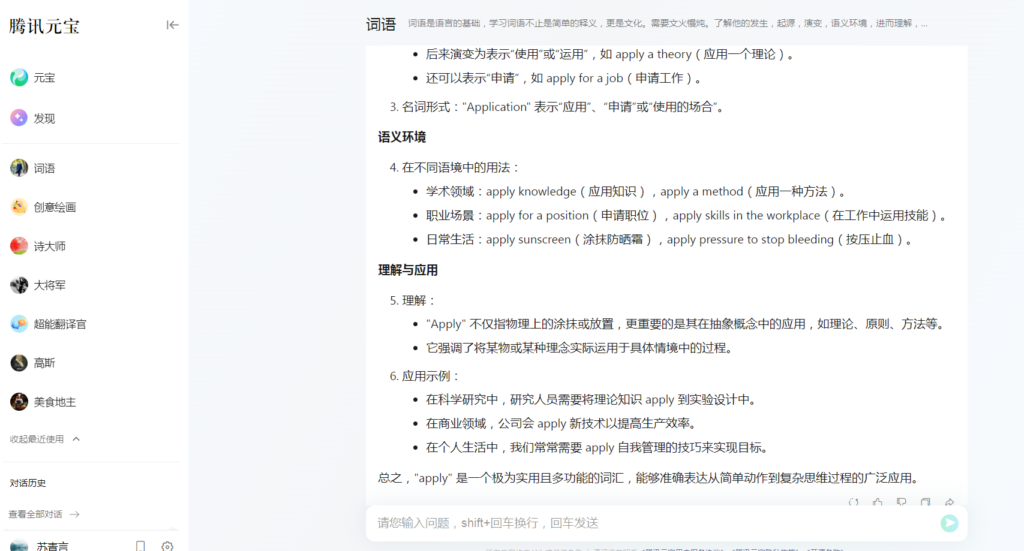

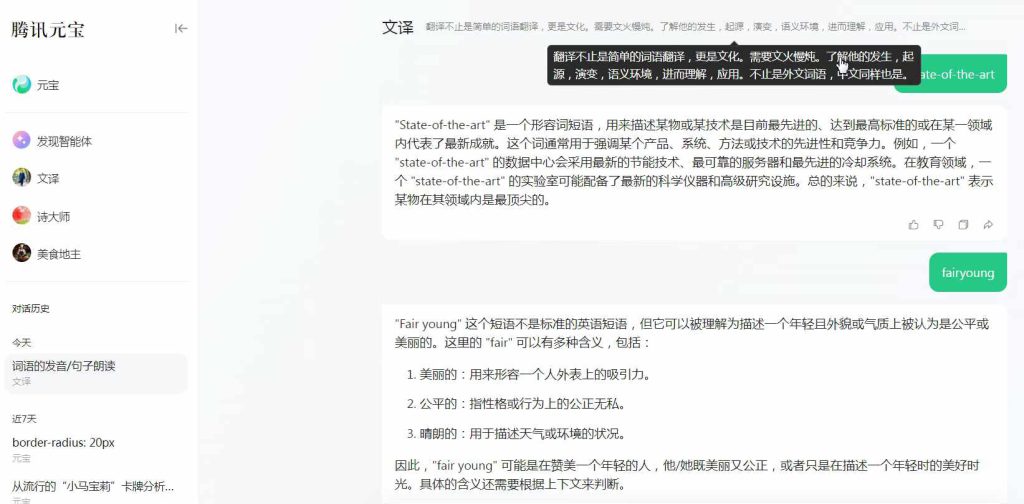

后来豆包,QQ等开始普及智能体。现在开始创建你的智能体,虽然同一个模型,不同的你,可以创建不同水平的不一样的智能体,比如我创建的“文译”,不管中外词语,都能从应用层面给出全面的回答,非常好用。

再看下元宝发现的“超能翻译官”:

现在,创建你的智能体。

目前头一批智能体大多是计算机工程运输人员建的,就像国内做大模型,调用一下国外大模型API。行业内的专业人士还未普及,没有下场。做大模型还是要和以往一样,咨询人员和业内业务人员共同完成最好,当然好的咨询专家本身就熟识业务,一个人就够了,“文译”就是这样,“文译”并不是一个简单的中英翻译,而是语言词语应用学习。

不知道“智能体”的发现方式什么?现在看互联网人在先,他们会“起名字”。

智能体现在在各家平台,是否可以像应用程序一样,可以跨平台,这样才有诞生“超级应用”的机会,打破平台的限制,或者平台赛跑最后留下来一两家。

现在正是业务人员入场的机会,是时候,下场了,建你的“智能体”!

目前智能体的应用,基于语言的最擅长,输入语言,输出语言,通过各种多模态,提供服务。

问题是,它是基于历史信息的,提供一些咨询与创作可以,要是做一些具体任务,就是工作层面的“苕萝卜”,比如编程,应对很快,但是丢前忘后,很费人,就是不能听话改正,实时学习,很像家长教小学生做题。

不能实时改正,即时交互体验不好,就是当前大模型应用的问题。问他怎么办:

在这方面,GPT40.mini更小,成本更低,功能更强,希望可以带来好的体验。

在模型能力已经很强的时候,如创作音乐,绘画,小说已经超过大部分专业人士,提高实时交互性能是亟需解决的一个方面。

为什么AI不是大家想要的AI

你一定见过这句话,“你想要AI扫地,洗碗,做饭,可是它在画画,写诗,唱歌”。这是因为信息技术从诞生到现在都是“程序化”的“存储结构”设计,就是你必须“预先”“存好””程序”才能按“程序”进行。你要快速实时处理,基本没有“现场口占”,只有“数据在传输前的先过滤等基本处理的”端边架构,你要实时处理还需要人进行现场工作对实时采集的数据进行分析。

而我们所说的做饭,洗碗等需要与环境的实时交互,需要实时做出响应,以及对环境及其他干预的应对,这不是可以提前预设的。这是现场性的交互性的任务。而我们说的画画,写诗,唱歌等这些看似是对人的创造性要求更高的活动,都是对过往的数据,历史知识进行总结,学习,在新的应用中并不必须强调交互性,现场性的任务,所以现在大模型在应答,绘画,唱歌等这些依据过往经验的“静态”应用中,效果很好,而对做饭,洗碗等这些活动,进展稍慢。其实华为已经实现了无图自动驾驶,自动驾驶就是与环境交互的一个方面的行业应用,目前已进入可以应对的高级自动驾驶阶段。

这是AI应用的一个分析。

现在大模型并不能被用户进行“交互性,实时性“教授,学习和改进,这也是大模型太大,训练周期长,也不能交互学习,还是像各位家长给孩子讲题一样,怎么讲过还不会,又错了。但是这个靠对过去知识讲解的领域,很适合大模型。这也是画画,写诗,唱歌这些依靠历史知识,静态任务,应用效果好的原因,因此行业上来讲一个AI老师比家长会耐心好多。

也就是说大模型在对静态任务,依靠过去知识的语言处理上效果更契合,比如翻译 ,问答,编程等。而大家认为要求更高的写诗,画画,这些其实都是一种语言,自然适合大语言模型。

给予这个问题问下大模型,看他们怎么解决:

这两天openAI刚发布了GPT4o mini,更小更便宜,用起来也会更省力更快,便于端侧部署,在模型能力相当强大时候,和用户的交互会是下一个亟需解决的问题。

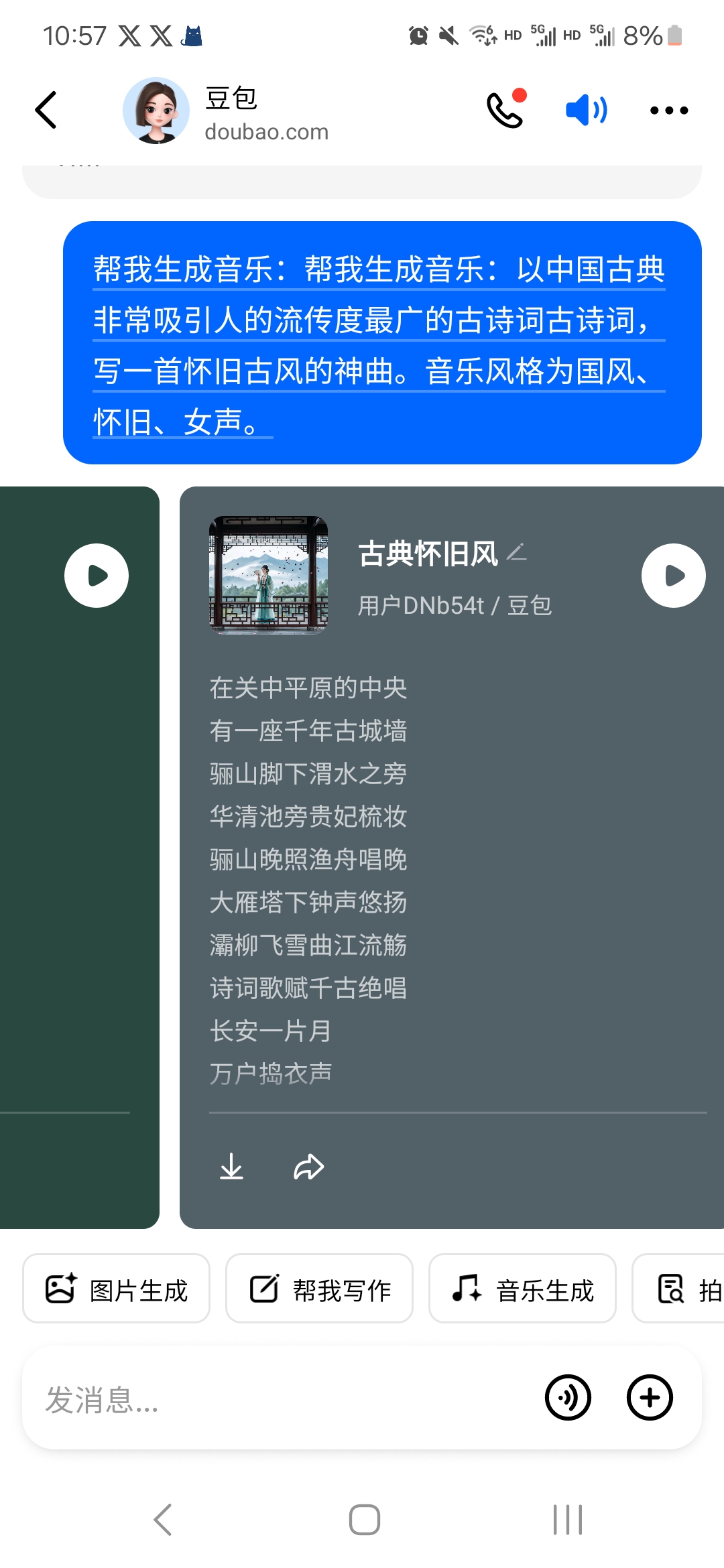

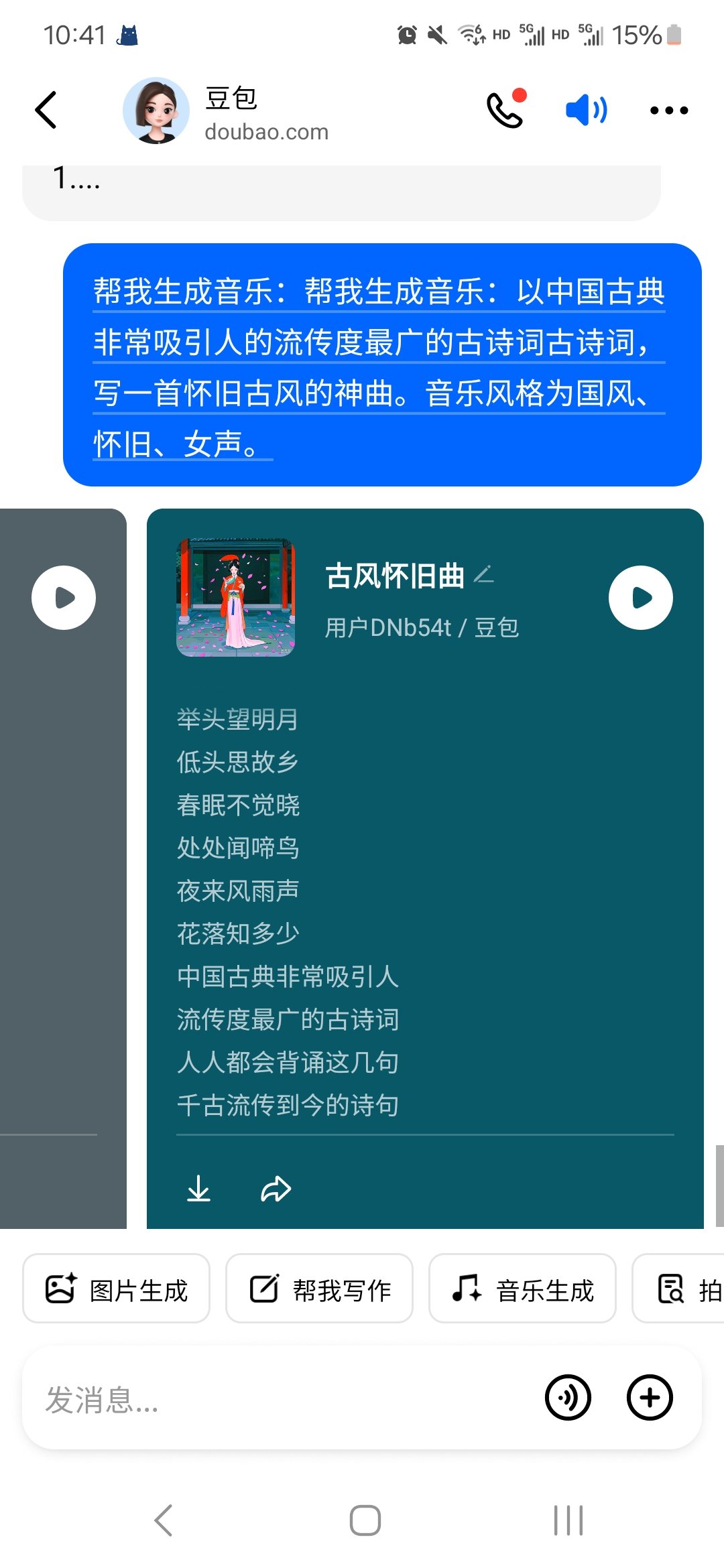

当你没有灵感时咋办

码农退出,QQ音乐无奈退出转搞技术服务,本青仙上场。QQ音乐写歌词可以,唱的技术差点,但他们会做产品,卖声音1号,声音2号,实现了我给Suno指导的,存储音色,实现了AI音乐一致性:唱歌,存储音色继续唱歌,发行歌曲,就差真人唱歌,这一个环节,就可以平台化,现在也可以平台化,可以让我教全民自己没有想法时怎么写歌,有用户才能平台化。中国文艺只分风雅颂和神曲。歌手2024最大意义在于让人见了歌王歌后都唱那些歌:自立。一般歌手唱不了没有那能力,一般网友也不听,不是风也哼不来。但这是正规化的必然之路,不然只能刘德华了。[尴尬]第1大问题,我们没有灵感怎么写歌,你不能像码农一上来都是吃,宫保鸡丁。第一,你要把AI当搭档,华山论剑,而不是实施人员,让人写麻婆豆腐。而是你要有起兴,一句两句就可以,人家可以给你华山论剑,直接唱一首。第2,你看见荷花自然可以想起一首接天莲叶无穷碧,这是大部分人都可以,然和再华山论剑写一首。第3,你得扩列,不能只听教科书编的,还有统领江南的杨广,寒鸦飞数点,流水绕孤舟。再华山论剑。第4,Suno搞了声音写歌法,有声响就能写歌。QQ搞了AI唱歌星。[玫瑰]这是解决创作来源和质量的问题,这个解决才有高质量供给。[爆竹]但也要解决人唱AI歌的问题。第1,AI出世后,才发现原来有原创音乐平台,一听就知道为啥刀郎可以🔥了!旭日阳刚可以🔥了!唱歌是最简单又最难的事情,没办法练不出来!现在AI唱歌已经超过85%人,网上那些直播歌手和音乐系,录音棚都没进过,让他们唱歌不现实,没谱他们他们弹不了,靠谱靠习惯了,这就是我讲的一开始就要[拳头]不靠谱[拳头]。所以要有把AI歌曲,同时生成曲谱的功能,这样可以找人靠谱演奏,QQ上传歌曲可以拆解歌词,国内有个APP可以生成曲谱,这个简单,技术可以搞定,问题还是写歌,写歌需要激发人的欲望和平静内心,激发简单,歌手都要泡吧,在喧嚣后的虚无的刹那产生空无的灵感!

纯AI音乐做平台,Suno在推广。

AI音乐的用户天然不多,尤其是中国工程化教育,你让自己出想法,给个起兴太难。歌星中创作歌手也非常稀少,一首歌吃一辈子,就说明了这个难度。

但是需要专业歌手进入,出一两首作品🔥了,就够了,平台就可以运营。